2003年炎天的一个周日,AI教父Hinton在多伦多大学的办公室里敲代码,突然响起略显冒失的敲门声。

门外站着一位年轻的学生,说自己整个炎天都在打工炸薯条,但更希望能加入Hinton的实验室事情。

Hinton问,你咋不预约呢?预约了我们才气好好谈谈。

学生反问,要不就现在吧?

这位年轻学生就是Ilya Sutskever,刚刚完成本科二年级的数学课程,从教务处探问到“想学机械学习,*去找Hinton教授”。

他照做了,也因此成就了一段传奇:

从AlexNet到AlphaGo,他两次介入改变天下的研究。

OpenAI确立之初挖他去当首席科学家,在他的向导下,推出了GPT系列早期版本、DALL·E系列、代码大模子Codex,直到ChatGPT,再次改变天下。

多年后,他发动董事会内讧,最终与OpenAI彻底分道扬镳,全天下都在守候着他的下一个动作。

在OpenAI的时刻,Ilya并不像Altman那样四处抛头露面,也不像Brockman天天在网上分享自己的“编程之禅”。

仅有的几回演媾和访谈中也多是聊手艺、宏观思索,不常谈及自己的履历,最近半年更是销声匿迹。

这次的故事,正是来自他的博士导师Geoffrey Hinton。

在与Sana Labs首创人的最新对话节目中,Hinton不仅讲了自己的事,还回忆了师徒共事时代的一些往事。

20多年已往了,许多细节在Hinton的叙述里照样那么鲜活。

这段访谈录像天经地义的火了,除了轶事之外,还涉及Ilya的一些学术头脑怎么来的,又是若何生长:

2010年Ilya就用GPU开发了一种语言模子

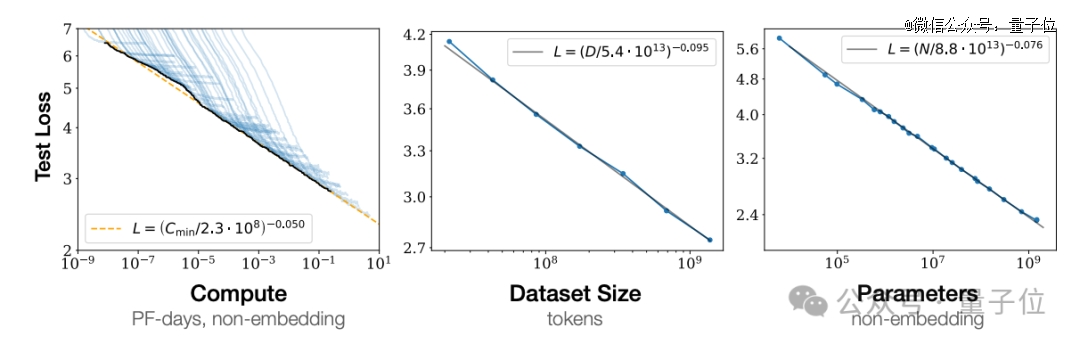

Scaling Law最早是他的一种直觉

两人都以为”语言模子不只是展望下一个token“

两人都认同“展望即压缩压缩即智能”

那么,Hinton眼中的Ilya,到底是什么样子?

惊人的原始直觉

Ilya加入实验室后,Hinton给他部署的*个义务是读论文,一篇关于反向流传的论文。

下一个周会,Ilya回来讲述了,说“我不明白”。

Hinton很失望,心里OS:“这孩子看着挺灵巧的,咋连链式规则求导这么基础的器械都看不懂?”

Ilya连忙注释,哦这个部门我懂了,我不明白的是,为什么不给梯度加一个sensible functional optimizer?

Hinto团队厥后花了好几年来解决这个问题,最初指出问题的却是刚入门一周的Ilya。

像这样的情形后面还在频频发生……Hinton云云评价Ilya:

他对事物的原始直觉总是异常好。

但Hinton也说搞不清晰Ilya这种直觉从何而来,或许归功于他从小就对人工智能问题感兴趣,再加上数学基础很棒。

除了研究直觉,学生时期的Ilya也展现了*的代码和工程能力。

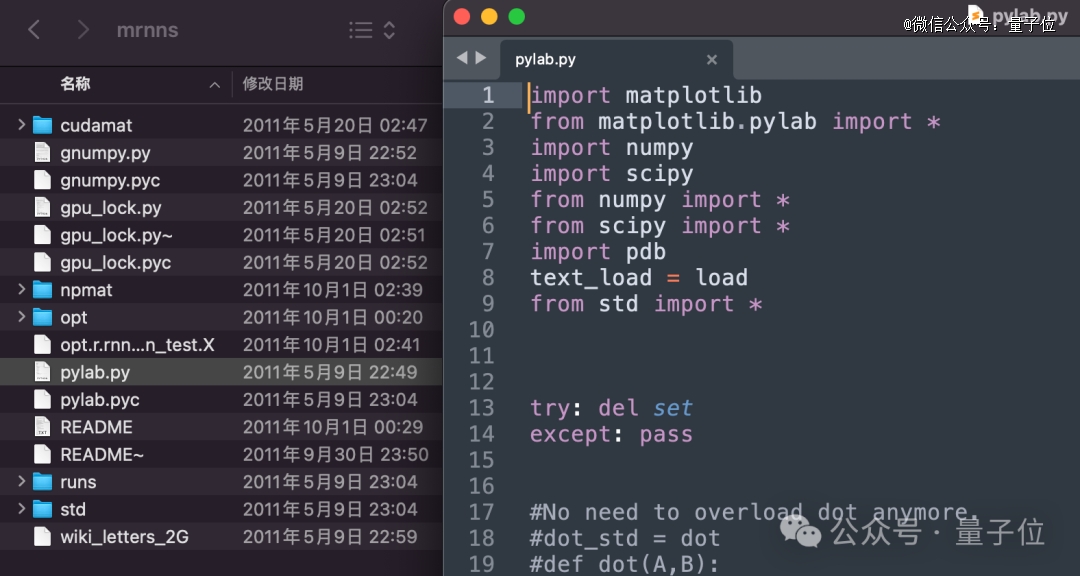

那时还没有TenserFlow或Torch之类盛行框架,机械学习的主要工具和平台是Matlab。

一项事情需要在Matlab里调整大量矩阵乘法代码,Ilya做了一段时间就很不耐性,说要为Matlab写一个界面:

我用其他(Python等更利便的)语言写代码,然后能自动转成Matlab代码就好了。

Hinton听说后语重心长劝他,你可别,这得花上一个月时间,我们不要分心,把手头项目先做完。

Ilya却轻描淡写地说,害,没事,今天早上我已经写完了。

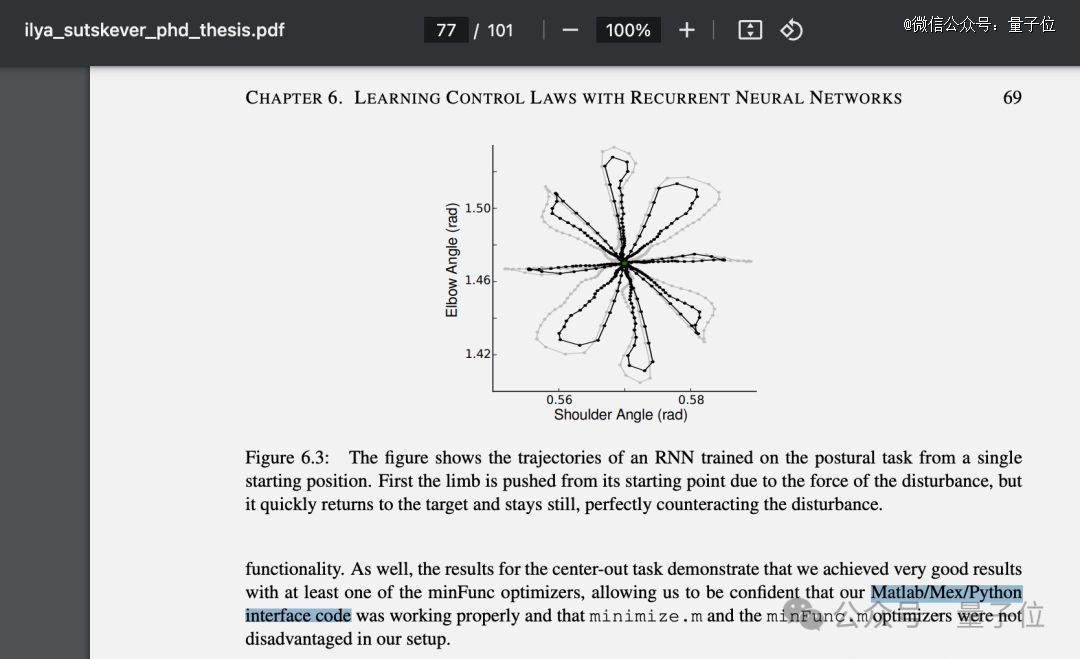

△这项事情泛起在Ilya的博士结业论文里

打小就坚信Scaling Law

正如Hinton所言,Ilya在许多问题上有惊人的直觉。

今天全AI圈不少人信仰的Scaling Law,Ilya学生时代就已坚信,并捉住种种时机向身边的人安利:

只要(把模子)做得更大,它们就会施展更好的作用。

厥后到OpenAI确立之初,Ilya的表述加倍完善了:

若是你有一个大而深的神经网络,可以在大量数据上举行训练,那么你现实上可以解决任何模式识别问题。

早年间Hinton看来,这就像是研究者在没有创新的想法时,一种“逃避责任”的显示。

那时的我错了,而Ilya基本上是对的。

好比Transformer确实是一种创新想法,但现实上起作用的照样规模,数据的规模和盘算的规模。

Hinton提到在昔时谁人时间节点,没人敢预料盘算机速率往后会快上10亿倍,最多想象到快100倍就不得了。

若是有今天的盘算机,昔时研究的难题可能会自行解决,包罗语言模子问题。

(此处应插入比尔盖茨曾预言64k内存就足够任何人用了笑话)

Ilya在2003年加入Hinton的实验室,不知详细何时最先有了Scaling Law的想法,可能在他脑海里已经盘旋了20多年。

厥后直到2020年,GPT-3宣布的几个月前,OpenAI团队才正式在论文中向众人完整界说和先容这一理念。

在语言模子上用GPU,比AlexNet更早

2010年底,Ilya和另一个学生James Martens(现DeepMind研究科学家)互助研究了一种语言模子,厥后入选ICML 2011。

RNN架构,使用维基百科数据,在8张那时*进的GPU上训练,比在AlexNet上使用GPU还早两年。

与今天的大语言模子展望下一个token纷歧样,那时他们实验的是一次展望一个字符。

这款模子能力有限,好比给一段起始文字,模子可以继续天生看起来像维基百科文章的语句。

菏泽南站只火了10天,但郭有才已经火3次了

虽然语意上像是胡言乱语,但语法和标点符号大部门是准确的,引号和括号已经能成对泛起,主语和动词形态一致,好比论文中的一段:

生命的意义是古代人类滋生的传统:对于好男孩什么时刻移除她更大的来说,并不是很有利。在这个节目的协议中,险些一致地重新浮现……

那时多伦多大学校刊的采访中,Ilya以为这已经超出了所有人的预期:

它发现了单词的存在,也发现了语法。

Hinton理智上也无法去信托这个系统能“明白”任何事,但它看起来就像是明白了。

好比给它一个地址组成的列表,它可以继续天生地址,只管还分不出国家和州的区别。

昔时的Ilya并不愿意讨论这项事情的潜在应用。

在维基百科上乐成后,团队又实验了纽约时报文章数据,目的是教会它凭证文字识别差异作者的身份。

但Ilya已经想到并认可,若是做的足够好,这项手艺有一天可能成为洗稿软件的基础。

现在,这篇论文的代码依然存放在多伦多大学的服务器上,供感兴趣的人研究。

不止是展望下一个token

厥后的AlexNet、师徒三人“拍卖”自己加入谷歌等人人已熟知的故事,这里先略过。

Ilya加入OpenAI后,虽然不再与Hinton共事,但两人的学术头脑始终在一条路上。

ChatGPT问世后,不少人指斥大模子本质上只是统计学,展望下一个token,就像随机模拟人类语言的鹦鹉。

但Hinton和Ilya师徒二人都以为,远不止云云。

在Hinton眼中,问题之后的下一个token,即是谜底的*个token。

因此学会展望,就意味着必须学会明白问题。

这种明白的方式与人类相似,同时与老式基于三元组数据的自动补全有基本差异。

今天我们现在已经看到了,做一个大语言模子,不刻意训练其推理能力,就发生了推理能力。

这就是大脑若何学习,你在展望视觉的下一帧、听觉的下一个声音。

Ilya更是竭尽全力流传这套理论,在去年和英伟达老黄的炉边对话中说了这个,在OpenAI内讧两周前最后一个公然采访中也讲了这个:

当我们训练一个大型神经网络来准确展望互联网上许多差异文本中的下一个单词时,我们所做的就是学习一个天下模子。

从外面上看,可能只是在学习文本中的统计相关性。

但事实证实,为了“只是学习”文本中的统计相关性,为了压缩它们,神经网络需要学习的是文本天生历程的某种示意。

文本现实上是对天下的投影。

在另一场采访中,他走的更远:

很好地展望下一个token,意味着领会缔造该token的深层现实。

这不仅是统计学,而是明白缔造了这些统计数字的谁人天下。

若是真的很善于展望下一个token,就可能凭证通俗人若何行动的数据,外推出拥有特殊智慧和洞察力的人若何行动,只管这种人可能并不存在。

这就是Ilya以为的,为什么“展望下一个token”范式有可能抵达AGI,甚至有可能逾越人类直至ASI。

展望即压缩,压缩即智能

在差异场所提到“展望下一个Token”时,Ilya也许率会同时提到“压缩”,他以为展望即是压缩,压缩就是智能的泉源。

但Ilya总是从理论的角度去注释这个想法,并不容易让所有人都能明白。

好比在UC Berkley的一场演讲中,他这样注释:

- “Kolmogorov压缩器”,是理论上能天生特定数据集的、长度最短的一段程序,能最小化遗憾值。

- 随机梯度下降,可以看成在软盘算机(好比大型Transformer)的权重里,搜索隐含的“Kolmogorov压缩器”。

- 神经网络越大,就越能更好的近似“Kolmogorov压缩器”,遗憾值越低。

Hinton也认同这个说法,而且在访谈中举了异常形象的例子。

大模子做的是寻找配合结构,使用配合结构编码事物,这样效率更高。

若是你问GPT-4堆肥和原子弹相似性在哪,大多数人类都回覆不出来,以为它们是异常差其余两种器械。

GPT-4会告诉你,虽然他们的能量规模差异,时间尺度差异,但仍有相同之处:

当堆肥变热时,发生热量的速率就更快。

当原子弹发生更多中子时,发生中子的速率也更快。

通过类比,AI就明白了“链式反映”的看法。

Hinton以为,AI在行使这种明白去将所有信息压缩到自己的权重中。

一但AI这样做了,那么它就有能力明白数百种人类还未见过的类比,这就是缔造力的泉源。

Hinton眼中什么是勤学生?

说回到两人相遇时,Hinton谈到,与他攀谈没多久就能看出他很伶俐。

再多攀谈一会,就能发现他有很好的直觉,而且善于数学。

以是选Ilya做学生是异常容易做出的决议。

那么若何挑选其他学生?Hinton也用了Ilya最善于的方式:随着直觉走。

若是一小我私人轻信别人告诉他的一切,那就太致命了。

不轻信他人,而是实验将新信息融入自己对天下的明白框架中,若是融入不进去,就拒绝,这是很好的战略。

若是试图吸收被见告的一切,最终会获得一个异常模糊的框架。信托一切,然则没有用处。

以是Hinton眼中的勤学生,应该拥有一个坚定的天下观,并试图摆弄输入的事实以顺应你的看法。

这样虽然也可能陷入笃信宗教或坚持致命错误,但我以为这种方式仍是准确的。

厥后我们也能看到,两人都是秉持这样的理念,坚持着“大模子不止是展望下一个token”,坚持着“展望即压缩,压缩即智能”。

他们也都坚持以为,这个天下应该加倍重视AI带来的风险,一个因此脱离了事情10年的谷歌,一个因此脱离了一手拉扯大的OpenAI。

Hinton访谈完整视频